12 февруари — Основателят на Xiaomi Лей Джун обяви изданието с отворен код на Xiaomi-Robotics-0, модел с въплътен Vision-Language-Action (VLA) с 4,7 милиарда параметри. Кодът, теглото на моделите и техническата документация вече са налични в GitHub и Hugging Face.

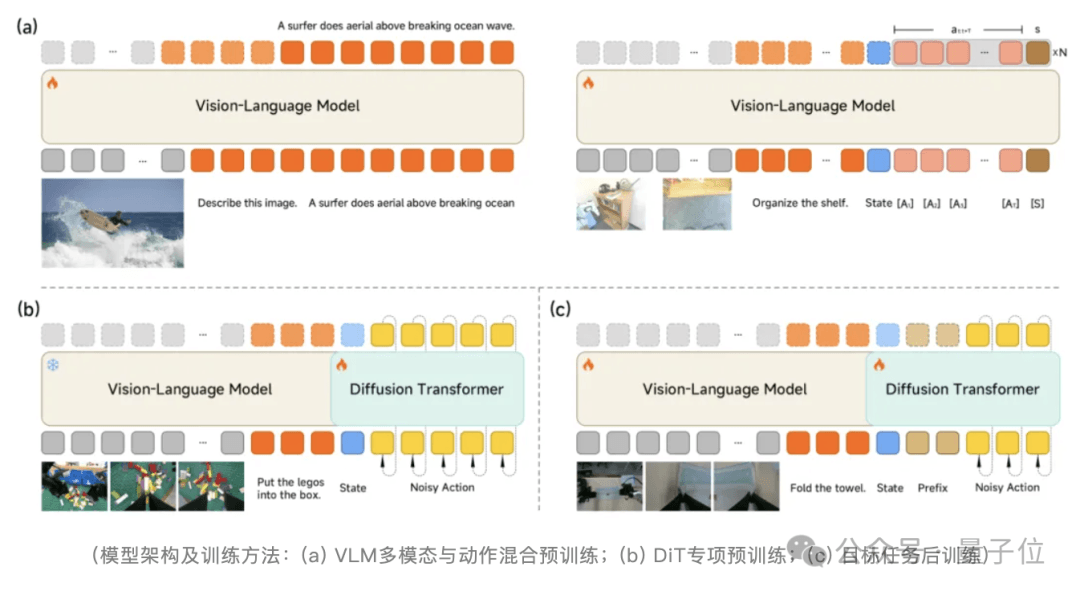

Моделът приема архитектура Mixture-of-Transformers, отделяйки Vision-Language Model (VLM) от 16-слоен дифузионен трансформатор (DiT). VLM управлява разбирането на инструкциите и пространственото разсъждение, докато DiT „моторният кортекс“ генерира високочестотни непрекъснати последователности на движение чрез съвпадение на потока.

Архитектурата постига латентност на извода от 80 милисекунди, поддържа 30Hz контрол в реално време и може да работи в реално време на GPU от потребителски клас като RTX 4090.

Обучението следва двуетапен подход за предварително обучение:

- Механизъм за предложение за действие принуждава VLM съвместно да прогнозира мултимодални разпределения на действие по време на визуално разбиране, подравняване на функции и пространства за действие.

- VLM е замразен, докато DiT е обучен да генерира прецизни последователности от движения.

След обучението се въвежда асинхронен извод и Λ-образна стратегия за маскиране на вниманието, отделяйки извода от времето на изпълнение, като същевременно дава приоритет на текущата визуална обратна връзка.

При симулация Xiaomi-Robotics-0 превъзхожда повече от 30 модела за сравнение – включително π0, OpenVLA, RT-1 и RT-2 – в наборите от данни LIBERO, CALVIN и SimplerEnv, постигайки множество нови резултати от SOTA. На задачата Libero-Object той достигна 100% успеваемост.

При внедряване в реалния свят, робот с две ръце, задвижван от модела, демонстрира стабилна координация око-ръка при задачи с дълъг хоризонт и висока DoF, като разглобяване на блок и сгъване на кърпа, като същевременно запазва възможностите за откриване на обекти и визуални отговори на въпроси.

Източник: QbitAI

Source link

Like this:

Like Loading…

Нашия източник е Българо-Китайска Търговско-промишлена палaта